Kas ir Googlebot?

Googlebot ir Google meklētājprogrammas automatizēta rāpuļprogramma (līdzīgi kā Bingbot), kas apmeklē un analizē tīmekļa vietnes, lai savāktu un indeksētu to saturu. Tas seko saitēm, skenē saturu un pievieno to Google meklēšanas indeksam, nodrošinot, ka lietotāji var atrast visatbilstošāko informāciju. Googlebot ievēro mājaslapas norādes robots.txt failā un XML vietnes kartē, tādējādi optimizējot indeksēšanu un meklējamību.

Kam ir paredzēts Googlebot?

Googlebot ir paredzēts, lai efektīvi indeksētu tīmekļa vietnes un padarītu to saturu pieejamu Google meklētājprogrammas lietotājiem. Tas analizē mājaslapu saturu, struktūru un saites, lai nodrošinātu to atbilstību meklētājprogrammas standartiem. Turklāt Googlebot palīdz identificēt tehniskās kļūdas un uzlabo SEO veiktspēju, ļaujot lietotājiem ātri un viegli atrast vēlamo informāciju.

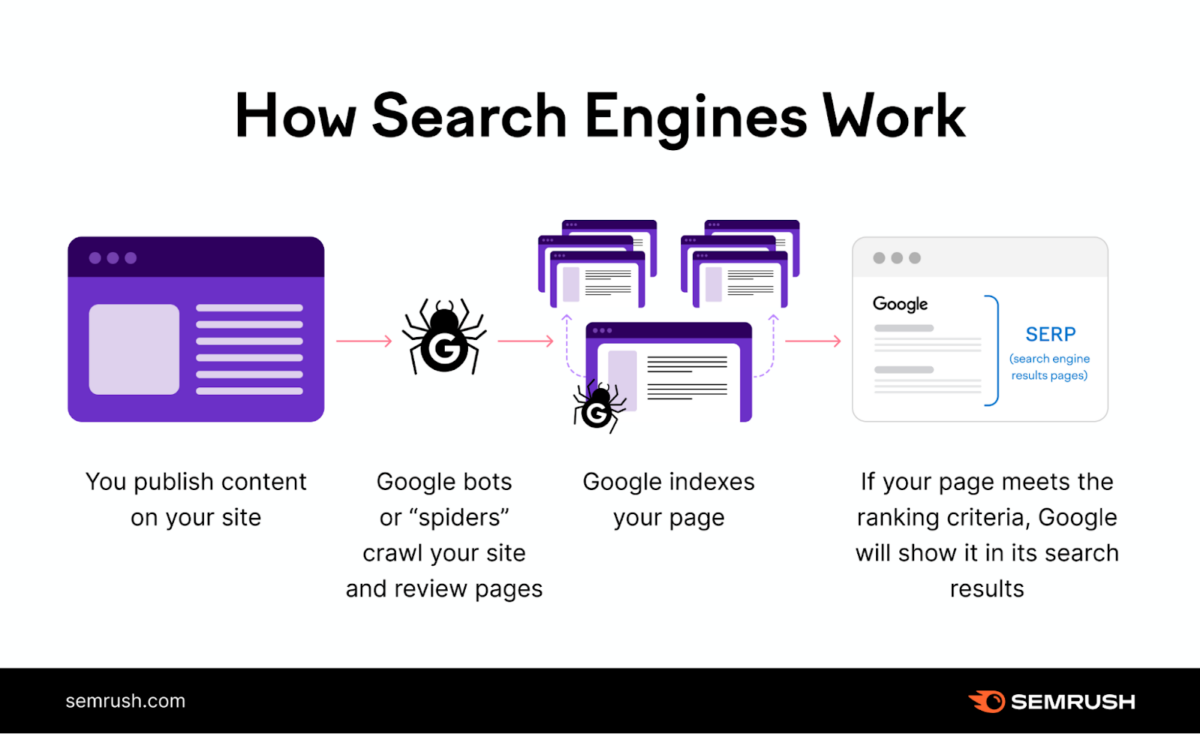

Googlebot darbība sastāv no šādiem posmiem:

1. Pārlūkošana (Crawling): Googlebot apmeklē tīmekļa lapas, izmantojot saites no citām vietnēm vai URL sarakstiem, kurus Google zina.

2. Indeksēšana (Indexing): Apkopotie dati no lapām tiek analizēti, un būtiskā informācija (saturs, atslēgvārdi, metadati) tiek saglabāta Google meklēšanas indeksā.

3. Atjaunināšana: Googlebot periodiski pārmeklē jau zināmās vietnes, lai reģistrētu izmaiņas un nodrošinātu, ka meklēšanas rezultāti ir aktuāli.

Avots: https://www.semrush.com/blog/googlebot/

Informācija par Googlebot:

- Divi galvenie Googlebot veidi: Googlebot darbojas divos režīmos: Googlebot Desktop (darbvirsmas lietotājiem) un Googlebot Mobile (mobilajām ierīcēm). Kopš 2021. gada Google indeksēšana tiek veikta, prioritizējot mobilās ierīces (mobile-first indexing).

- Googlebot un robots.txt: Robots.txt fails ļauj mājaslapu īpašniekiem kontrolēt, kuras lapas Googlebot drīkst vai nedrīkst indeksēt. Tas ir svarīgs SEO rīks, lai novērstu nevēlamu lapu nokļūšanu meklēšanas rezultātos.

- Googlebot meklēšana: Googlebot izmanto saites, XML vietnes kartes un iepriekšēju indeksēšanas vēsturi, lai noteiktu, kuras lapas apmeklēt. Augstāk prioritāti iegūst lapas ar jaunu vai atjauninātu saturu.

- Crawl Budget: Googlebot piešķir katrai mājaslapai noteiktu “crawl budget” – cik bieži un cik daudz lapu tas apmeklē konkrētajā vietnē. Optimizēta vietne ar ātru ielādi un kvalitatīvu saturu ļauj maksimāli izmantot šo budžetu.

- Googlebot kļūdu diagnosticēšana: Izmantojot Google Search Console, mājaslapu īpašnieki var pārbaudīt, kā Googlebot redz viņu vietni, identificēt indeksēšanas problēmas un veikt nepieciešamos uzlabojumus, piemēram, izlabot 404 kļūdas vai pārlūkojamības problēmas.

Biežāk uzdotie jautājumi

Kas ir Googlebot un kā tas darbojas?

Googlebot ir Google meklētājprogrammas automatizēts rāpuļprogramma (web crawler), kas apmeklē un analizē tīmekļa vietnes. Tas seko saitēm, skenē saturu un pievieno to Google indeksam. Googlebot ievēro mājaslapas norādes robots.txt failā un XML vietnes kartē, lai saprastu, kuras lapas drīkst apstrādāt un indeksēt.

Kā zināt, vai Googlebot apmeklē manu mājaslapu?

Lai pārbaudītu, vai Googlebot apmeklē jūsu mājaslapu, izmantojiet servera žurnālfailus (server logs), kur ir norādītas visas rāpuļprogrammas darbības. Turklāt Google Search Console sniedz detalizētu informāciju par indeksēšanu, kļūdām un lapām, kuras Googlebot ir apmeklējis vai mēģinājis apmeklēt.

Kā ierobežot Googlebot piekļuvi noteiktām lapām?

Lai kontrolētu Googlebot piekļuvi, izmantojiet robots.txt failu, kurā iespējams norādīt direktīvas, piemēram, “Disallow”, lai bloķētu konkrētas lapas vai direktorijus. Papildus var izmantot meta tagus ar “noindex”, lai nodrošinātu, ka noteikts saturs netiek pievienots meklēšanas indeksam.

Vai Googlebot indeksē JavaScript saturu?

Jā, Googlebot spēj apstrādāt un indeksēt JavaScript saturu, taču tas var būt sarežģīts process. Ir svarīgi nodrošināt, ka JavaScript ģenerētais saturs ir redzams arī bez JavaScript. Izmantojiet Google Search Console un tās “URL pārbaudes” rīku, lai pārbaudītu, kā Googlebot renderē jūsu lapas.

Kas ir Googlebot “crawl budget” un kā to optimizēt?

Googlebot crawl budget ir resurss, ko Google piešķir jūsu mājaslapas lapu indeksēšanai. Optimizācija ietver ātrākas ielādes laika nodrošināšanu, nevajadzīgu lapu bloķēšanu ar robots.txt failu un XML vietnes kartes izveidi. Jo efektīvāk tiek izmantots rāpošanas budžets, jo vairāk svarīgas lapas Googlebot var indeksēt.