Definīcija. Kas ir robots.txt fails?

robots.txt fails (robots.txt file) ir tīmekļa servera konfigurācijas fails, kas nosaka, kā meklētājprogrammas roboti (spiders vai crawlers) drīkst piekļūt un indeksēt tīmekļa vietnes saturu. Tas norāda, kuras tīmekļa vietnes sadaļas ir atļauts vai aizliegts indeksēt, tādējādi kontrolējot, kāda informācija tiek parādīta meklētājprogrammu rezultātos. Pareizi konfigurēts robots.txt fails ir būtisks, lai optimizētu vietnes meklētājprogrammu veiktspēju un nodrošinātu nevēlamu lapu un failu nepieejamību meklētājprogrammu robotiem.

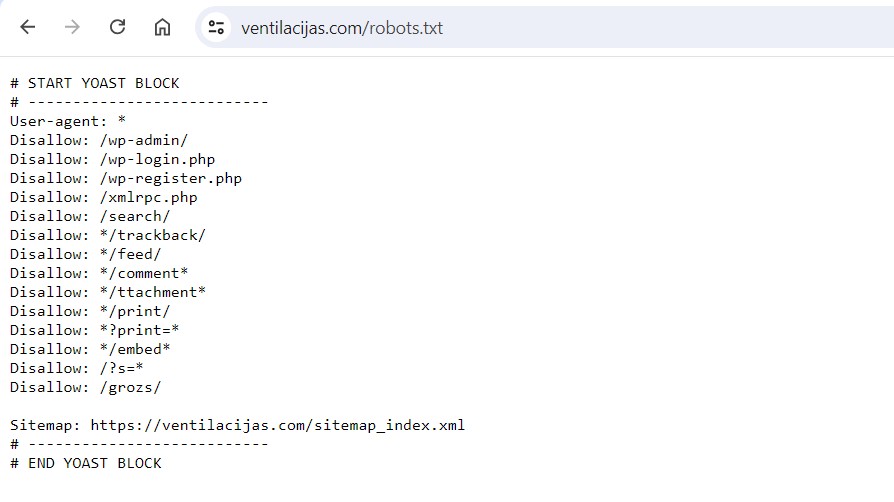

WordPress robots.txt faila piemērs

Šeit ir piemērs WordPress robots.txt failam, kas paredzēts, lai nodrošinātu optimālu meklētājprogrammu robotu piekļuvi un aizsargātu noteiktas WordPress vietnes daļas:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

# Aizliedz piekļuvi jebkuram URL, kas satur pievienotā vārda jautājuma zīmi (?)

Disallow: /*?

# Atļauj piekļuvi attēliem, jo tie ir būtiski SEO

Allow: /wp-content/uploads/

# Sitemap norāde

Sitemap: https://www.yoursite.com/sitemap.xmlKur atrast robots.txt failu savā mājaslapā?

Robots.txt failu var atrast jebkuras tīmekļa vietnes saknes direktorijā, un tas ir viegli pieejams, izmantojot pārlūkprogrammu. Lai pārbaudītu robots.txt faila saturu konkrētai mājaslapai, sekojiet šiem soļiem:

1. Atveriet pārlūkprogrammu: Atveriet jebkuru interneta pārlūkprogrammu, piemēram, Chrome, Firefox vai Safari.

2. Ievadiet vietnes URL: Adreses joslā ierakstiet mājaslapas URL, pievienojot “/robots.txt” beigās. Piemēram, ja vēlaties apskatīt vietnes “www.majaslapaspiemers.lv” robots.txt failu, ievadiet:

www.majaslapaspiemers.lv/robots.txtNospiediet Enter: Pēc URL ievadīšanas nospiediet Enter, lai pārlūkprogramma ielādētu robots.txt failu.

Pēc šo soļu izpildes pārlūkprogrammā tiks attēlots attiecīgās vietnes robots.txt fails, kurā redzēsiet norādījumus meklētājprogrammu robotiem. Šajā failā var būt norādīts, kuras vietnes sadaļas ir atļauts vai aizliegts indeksēt. Šādi viegli varat pārbaudīt un analizēt, kā tiek kontrolēta meklētājprogrammu robotu piekļuve jūsu vai citas tīmekļa vietnes saturam.

Kā robots.txt fails ietekmē SEO optimizācijas rezultātus

Robots.txt fails ir būtisks SEO optimizācijas rīks, kas palīdz kontrolēt meklētājprogrammu robotu piekļuvi jūsu vietnes saturam. Pareizi konfigurēts robots.txt fails var ievērojami uzlabot jūsu vietnes indeksāciju un vispārējo SEO rezultātus.

1. Indeksācijas kontrole: Robots.txt fails ļauj noteikt, kuras lapas un direktorijas meklētājprogrammas drīkst indeksēt un kuras ne. Tas ir īpaši svarīgi, lai izvairītos no dublētā satura un nodrošinātu, ka meklētājprogrammas koncentrējas uz svarīgākajām jūsu vietnes lapām.

2. Servera resursu pārvaldība: Ar robots.txt faila palīdzību varat novirzīt meklētājprogrammu robotus prom no resursietilpīgām vietnes daļām, piemēram, no attēliem vai skriptiem, kas nav būtiski meklēšanas rezultātiem. Tas palīdz efektīvāk izmantot servera resursus un uzlabot vietnes ātrumu, kas ir svarīgs SEO faktors.

3. Privātuma nodrošināšana: Robots.txt failu var izmantot, lai aizsargātu konfidenciālu informāciju un nepieļautu tās indeksāciju. Piemēram, varat bloķēt piekļuvi administrācijas panelim, lietotāju datiem vai jebkurām citām sensitīvām lapām.

4. Vietnes struktūras norādes: Ar norādi uz vietnes karti (sitemap) robots.txt failā varat palīdzēt meklētājprogrammām vieglāk atrast un indeksēt visas jūsu vietnes lapas. Tas uzlabo indeksācijas efektivitāti un palielina iespēju, ka viss svarīgais saturs tiks iekļauts meklēšanas rezultātos.

3 Biežāk pieļautās kļūdas ar robots.txt failu un kā tās novērst

Robots.txt fails ir svarīgs rīks, lai kontrolētu meklētājprogrammu robotu piekļuvi jūsu vietnes saturam. Tomēr nepareiza tā konfigurācija var negatīvi ietekmēt jūsu vietnes SEO rezultātus. Šeit ir trīs biežāk pieļautās kļūdas un padomi, kā tās novērst.

1. Nepareizi bloķētas svarīgas lapas

Kļūda: Bieži vien tīmekļa vietņu īpašnieki kļūdaini bloķē piekļuvi svarīgām lapām, piemēram, galvenajai lapai, emuāra rakstiem vai produktu lapām, neapzinoties, ka tas liedz meklētājprogrammām tās indeksēt.

Risinājums: Rūpīgi pārskatiet savu robots.txt failu un pārliecinieties, ka neviena no svarīgākajām lapām nav bloķēta. Piemēram:

Disallow: /wp-admin/

Allow: /Šādā konfigurācijā tiek bloķēta piekļuve administrācijas panelim, bet visas citas lapas ir pieejamas indeksācijai.

2. Bloķēta JavaScript un CSS failu piekļuve

Kļūda: Dažkārt tīmekļa vietņu īpašnieki bloķē piekļuvi JavaScript un CSS failiem, uzskatot tos par mazsvarīgiem. Tomēr šie faili ir būtiski, lai meklētājprogrammas varētu pareizi renderēt un saprast vietnes struktūru un izskatu.

Risinājums: Nodrošiniet, ka JavaScript un CSS faili nav bloķēti jūsu robots.txt failā:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Allow: /wp-includes/Šādā veidā tiek ļauta piekļuve visiem svarīgajiem failiem, lai meklētājprogrammas varētu pilnībā saprast jūsu vietnes saturu un struktūru.

3. Aizmirsts robots.txt faila testēšana

Kļūda: Daudzi tīmekļa vietņu īpašnieki neizmanto pieejamos rīkus, lai pārbaudītu savu robots.txt failu, tāpēc iespējams, ka tas nedarbojas kā plānots.

Risinājums: Izmantojiet Google Search Console robots.txt testeri, lai pārbaudītu savu robots.txt failu un pārliecinātos, ka tas darbojas pareizi. Šis rīks palīdzēs identificēt un labot jebkādas problēmas failā.

Pārbaudiet savu robots.txt failu:

- Pierakstieties Google Search Console.

- Izvēlieties savu īpašumu.

- Dodieties uz sadaļu “Crawl” un izvēlieties “robots.txt Tester”.

- Ievadiet savu robots.txt faila saturu un pārbaudiet, vai tas darbojas pareizi.

Izvairoties no šīm biežākajām kļūdām un regulāri pārbaudot savu robots.txt failu, jūs varat nodrošināt, ka jūsu vietne tiek pareizi indeksēta, kas veicina labākus SEO rezultātus un uzlabo jūsu vietnes redzamību meklētājprogrammās.

Kopsavilkums

Secinājumos var teikt, ka robots.txt fails ir būtisks SEO optimizācijas rīks, kas palīdz kontrolēt meklētājprogrammu robotu piekļuvi jūsu tīmekļa vietnei. Pareizi konfigurēts robots.txt fails var ievērojami uzlabot vietnes indeksāciju, aizsargāt privātu informāciju un efektīvāk izmantot servera resursus. Izvairieties no biežākajām kļūdām, piemēram, svarīgu lapu vai failu nepareizas bloķēšanas, un regulāri pārbaudiet failu, lai nodrošinātu tā pareizu darbību. Šādi rīkojoties, jūs veicināsiet labākus SEO rezultātus un uzlabosiet savas vietnes redzamību meklētājprogrammās.